Objective 3.1: Manage vSphere Storage Virtualization

Discover new storage LUNs

Cuando hemos realizado cambios en la infraestructura de almacenamiento, es posible que sea necesario volver a escanear el almacenamiento desde el servidor ESXi para detectar esos cambios. El procedimiento es el siguiente:

- Accedemos al servidor host, cluster o datacenter en el que queremos ejecutar el escaneo. Al hacerlo a nivel de host, aislamos el escaneo a un unico servidor. Si lo hacemos a nivel de cluster o datacenter, todos los hosts realizarán el escaneo

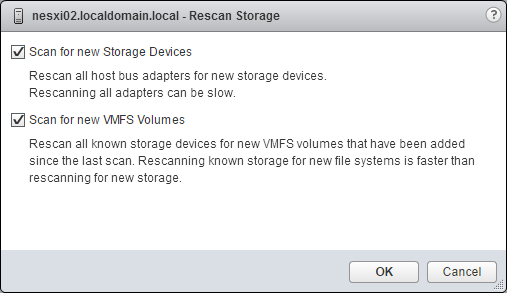

- Accedemos a Storage -> Rescan Storage

- Podemos especificar el tipo de escaneo:

- Scan for New Storage Devices: se examinan todos los adaptadores para detectar nuevos dispositivos de almacenamiento. Si se detectan nuevos dispositivos, estos aparecen en el listado de dispositivos.

- Scan for New VMFS Volumes: se examinan todos los dispositivos para detectar nuevos datastores. Todos los nuevos datastores aparecen en la vista de almacenamiento.

Podemos también realizar el escaneo a nivel de adaptador de forma individual. Para ello

- Accedemos al host

- Accedemos a Manage -> Storage -> Storage Adpaters

- Seleccionamos el adaptador y pinchamos en Rescan Adapter

Configure FC/iSCSI/FCoE LUNs as ESXi boot devices

ESXi permite realizar la instalación y configurar el arranque para que se utilicen discos remotos a través de protocolos como FC, iSCSI o FCoE.

Arranque desde FC

Requisitos:

- Cada host debe tener acceso solo a su propia LUN de arranque.

- No se puede habilitar multipath en entornos con almacenamiento Activo-Pasivo.

- Es necesario utilizar un switch SAN. No se pueden utilizar conexiones directas del host al almacenamiento.

Los pasos para configurar el arranque desde FC son:

- Configurar los componentes de la SAN y del sistema de almacenamiento

- Comprobar que el cableado es correcto

- Dara acceso en el sistema de almacenamiento al servidor ESX con los WWPN correspondientes

- Crear la LUN

- Asignar la LUN al servidor

- Configurar el adaptador de almacenamiento del servidor para arrancar desde la SAN

- Depende del fabricante y modelo del adaptador HBA, pero los pasos básicos son:

- Acceder a la configuración de adaptador en el arranque (ya sea por BIOS o UEFI)

- Habilitar el arranque desde la SAN en el adaptador seleccionado

- Indicar la LUN de arranque

- Depende del fabricante y modelo del adaptador HBA, pero los pasos básicos son:

- Configurar el servidor para realizar la instalación

- Realizar la instalación del servidor arrancando desde el medio que tenga la imagen de instalación de ESXi

Aranque desde FCoE

ESXi admite el arranque desde adaptadores red compatibles con FCoE. El adaptador de red debe admitir uno de los siguientes formatos:

- Tabla de firmware de arranque de FCoE (FBFT, es propiedad de Intel)

- Tabla de parámetros de arranque de FCoE (FBPT)

Los parámetros de configuración se establecen en la ROM del adaptador. Durante la instalación o el arranque de ESXi estos parámetros se exportan a la memoria en formato FBFT o FBPT y son accesibles por el VMkernel.

Requisitos

- ESXi 5.1 o superior

- El adaptador debe de:

- Ser compatible con FCoE

- Admitir el stack de FCoE de ESXi

- Contener un firmware que utilice FBFT o FBPT

- No se puede cambiar la configuración de arranque de FCoE desde ESXi

- No se permite multipath

- La LUN de arranque no se puede compartir con otros hosts

- No está soportado Coredump

- En el caso de utilizar adaptadores Inel con switch Cisco, se recomienda:

- Habilitar Spanning Tree Protocol (STP)

- Desactivar switchport trunk native vlan en la VLAN

El procedimiento de configuración es:

- Configurar los parámetros de arranque de FCoE de software

- Depende del fabricante del adaptador, pero este paso suele incluir configurar la VLAN ID, la LUN de arranque ...

- Instalación y arranque de ESXi desde LUN FCoE de software

- Configuramos el sistema para poder arrancar desde la imagen de instalación de ESXi. Durante la instalación, el sistema crea un switch standard con el nombre VMware_FCoE_vSwitch.

Arranque desde iSCSI

ESXi admite arranque desde SAN iSCSI con:

- iSCSI de hardware independiente

- iSCSI de software e iSCSI de hardware dependiente con un adaptador iBFT

Se recomienda:

- Seguir las instrucciones de los fabricantes

- Utilizar direcciones IP estáticas

- Utilizar LUNs diferentes para arranque y datastores VMFS

- La LUN de arranque debe de ser visible solo por el host que usa la LUN

- Solo con iSCSI de hardware se puede utilizar la partición de diagnóstico en una LUN de arranque. Con un arranque

El procedimiento es:

- Preparar el almacenamiento iSCSI

- Comprobar la conectividad de los cables

- Comprobar la conectividad IP

- Crear una LUN

- Configurar los permisos de acceso, ya sea mediante ACL o CHAP.

- Configurar el adaptador iSCSI

- Confiruar el adptador en el arranque indicando, dirección IP del inciador iSCSI, máscara de red, nombre iSCSI, CHAP (si es necesario), LUN de arranque

- Realizar la instalación del servidor ESXi

- Arrancamos el sistema desde el medio que contiene la imagen de instalación de ESXi y seleccionamos el destino iSCSI como destino de la instalación

iBFT es un método de comunicación de parámetros del dispositivo de arranque de iSCSI con el sistema operativo y se utiliza con arranques de iSCSI de software

Create an NFS share for use with vSphere

VMware ESXi incluye un cliente NFS que soporta el uso de NFS versión 3 y versión 4.1. Para crear un recurso en un servidor NFS que se va a utilizar en la infraestructura vSphere, debemos tener en cuenta:

- El servidor NFS debe de estar en la lista de compatibilidad de VMware (VMware HCL)

- Debemos seguir las recomendaciones del fabricante

- Exportar el share como NFS 3 o NFS 4.1, pero no los dos a la vez.

- Si se utiliza NFS 3 y NFS 4.1 sin soporte Kerberos, nos debemos de asegurar que los host tienen acceso de root al volumen. Normalmente se realiza utilziando la opción no_root_suash

- Si el volumen NFS es Read-Only, exportarlo como read-only o configurar el datatore en el ESXi como read-only.

- El host requiere un adaptador de red.

- ESXi soprota switch de capa 2 y 3.

- Se requiere un puerto VMkernel.

- NFS 3 y NFS 4.1 sin soprote kerbereos soportan IPv4 e IPv6

- Para utilizar NFS 4.1 tenemos que utilizar vSphere 6.x

- En un mismo host pueden coexistir datastores con NFS 3 y NFS 4.1

- vSphere no soporta la actualización de datastores NFS 3 a NFS 4.1

- Con NFS 3 nos debemos de asegurar que todos los servidores host ven el share con el mismo servidor y nombre de carpeta.

Diferencias entre NFS versión 3 y NFS versión 4.1

- NFS versión 3

- El tráfico no está encriptado

- No soporta multipath

- Necesita acceso root

- Soporta aceleración Hardware (VAAI)

- Con VAAI soportado, se pueden crear discos Thick provisioned

- VMware proporciona su protocolo propio de bloqueo mediante archivos.

- NFS versión 4.1

- Soporta multipath

- No soporta hardware acceleration

- Soporta Kerberos como protocolo de autenticación

- Usa reservas re recursos como mecanismo de bloqueo

- Admite el bloqueo de archivos

- Permite el acceso sin root cuando se utiliza Kerberos

| Característica vSphere | NFS versión 3 | NFS versión 4.1 |

|---|---|---|

| vMotion y Storage vMotion | Si | Si |

| High Availability (HA) | Si | Si |

| Fault Tolerance | Si | Si |

| Distributed Resource Scheduler (DRS) | Si | Si |

| Host Profiles | Si | Si |

| Storage DRS | Si | No |

| Storage I/O Control | Si | No |

| Site Recovery Manager | Si | No |

| Virtual Volumes | Si | No |

Enable/Configure/Disable vCenter Server storage filters

Cuando se realizan operaciones de administración en los datastores VMFS, vCenter utiliza filtros para proteger y evitar daños en el almacenamiento, de forma que se evite mostrar dispositivos que no son compatibles para una operación determinada. Los filtros disponibles son:

- config.vpxd.filter.vmfsFilter: filtro de VMFS. Si está en false permite sobreescribir un volumen VMFS o utilizarlo como RDM

- config.vpxd.filter.rdmFilter: filtro de RDM. Si está en false permite utilizar el volumen como RDM en varias máquinas de forma simultánea.

- config.vpxd.filter.SameHostAndTransportsFilter: filtro de mismo host y transportes. Si está en false permite añadir una LUN no compatible (por ejemplo que no sea vista por todos los hosts) como extend de un datastore existente.

- config.vpxd.filter.hostRescanFilter: filtro de nuevo escaneo. Permite, por ejemplo, desactivar el reescaneo automático que realizan los hosts cuando se crea un datastore VMFS nuevo. Por ejemplo si quieremos añadir varios datastores y queremos que unicamente se produzca un escaneo al terminar de crear todos los datastores. En false el esceneo automático está deshabilitado.

Salvo el último filtro, como norma general, se debe de evitar el uso de estos filtros.

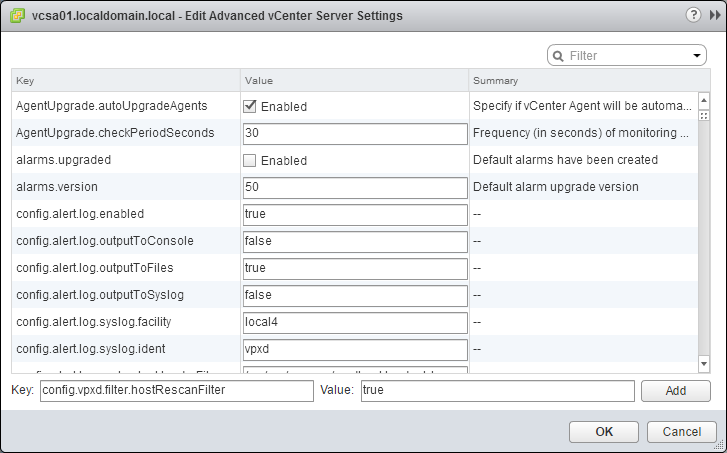

Habilitar los filtros

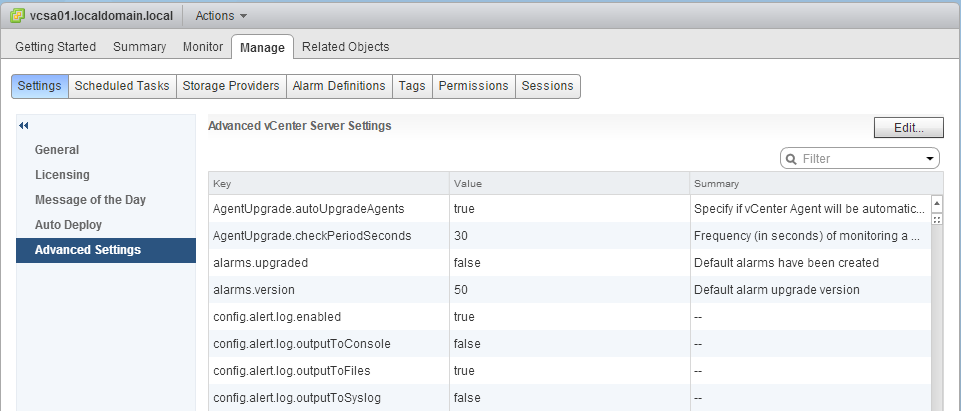

- Accedemos al servidor vCenter en el cliente web

- Accedemos a Manage -> Settings -> Advanced Settings

- Pinchamos en el botón Edit

- Buscamos si existe el fitro, si no lo creamos

- config.vpxd.filter.vmfsFilter

- config.vpxd.filter.rdmFilter

- config.vpxd.filter.SameHostAndTransportsFilter

- config.vpxd.filter.hostRescanFilter

- En el campo Value escribimos True para la clave correspondiente

- No es necesario reiniciar el vCenter

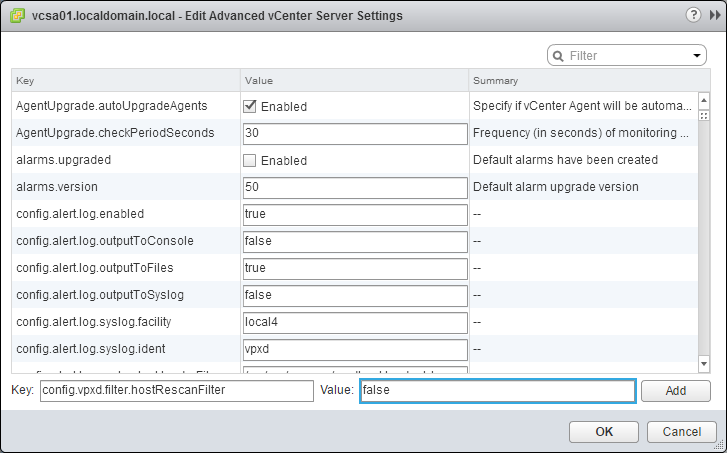

Desactivar los filtros

- Accedemos al servidor vCenter en el cliente web

- Accedemos a Manage -> Settings -> Advanced Settings

- En el cuadro de búsqueda introducimos el nombre de la clave correspondiente

- config.vpxd.filter.vmfsFilter: filtro de VMFS

- config.vpxd.filter.rdmFilter: filtro de RDM

- config.vpxd.filter.SameHostAndTransportsFilter: filtro de mismo host y transportes

- config.vpxd.filter.hostRescanFilter: filtro de nuevo escaneo. Permite, por ejemplo, desactivar el rescaneo automático que realizan los hosts cuando se produce un

- En el campo Value escribimos False para la clave correspondiente

- No es necesario reiniciar el vCenter

Configure/Edit hardware/dependent hardware initiators

Es posible modificar el alias y el nombre iSCSI asignados de forma predeterminada a los adaptadores iSCS de hardware.

- Accedemos al host en el cliente web

- Acedemos a Manage -> Storage -> Storage Adapters

- Seleccionamos el adaptador y accedemos a Properties

- Podemos cambiar el nombre iSCSI y el alias

Enable/Disable software iSCSI initiator

Enable software iSCSI initiator

- Accedemos al servidor ESXi

- Manage -> Storage -> Storage Adapters

- Pinchamos en el símbolo + y seleccionamos Software iSCSI adapter

- Aceptamos la pregunta pinchando en OK

- Comprobamos que se ha añadido el nuevo adaptador

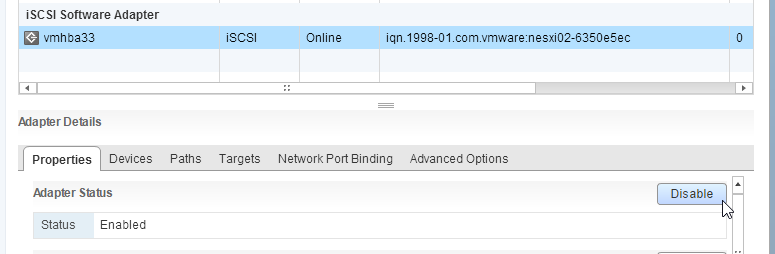

Disable software iSCSI initiator

- Accedemos al servidor ESXi

- Manage -> Storage -> Storage Adapters

- Seleccionamos el iSCSI Software Adapter y pinchamos en Disable

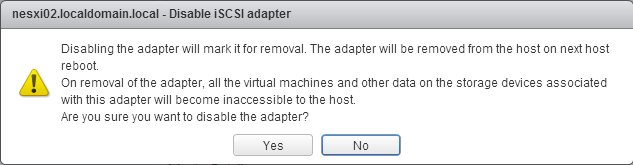

- Aceptamos el mensaje de advertencia en el que se nos indica que para completar la tarea tenemos que reiniciar el servidor host

- Reiniciamos el servidor ESXi

Configure/Edit software iSCSI initiator settings

Una vez que hemos habilitado el iSCSI Software adapter, podemos configurar diferentes opciones

- Podemos cambiar el nombre iSCSI y el Alias

- Podemos añadir el Target (servidor remoto)

- Indicando el nombre del servidor iSCSi

Configure iSCSI port binding

- Accedemos a la pestaña Network Port Binding del adaptador iSCSI

- Seleccionamos el puerto vmkernel que vamos a utilizar.

- Para poder utilizar un puerto VMkernel es necesario que la configuración de Teaming sólo tenga un interfaz como Active (no puede haber otros interfacces en la sección de Active o de Standby)

- Si quiremos utilizar Multipath podemos añadir varios interfaces

Enable/Configure/Disable iSCSI CHAP

Podemos configurar iSCSI CHAP a dos niveles:

- En el adaptador

- En la conexión con el Target

Tenemos la opción de seleccionar 4 tipos de autenticación:

| CHAP Authentication | Descripción | Soportado |

|---|---|---|

| None | El host no usa CHAP | Software iSCSI, Dependent hardware iSCSI y Independent hardware iSCSI |

| Use unidirectional CHAP if required by target | El host prefiere no uilizar CHAP pero la usa si lo requiere el target | Software iSCSI, Dependent hardware iSCSI |

| Use unidirectional CHAP unless prohibited by target | El host prefiere CHAP pero no lo utiliza si el target no lo soporta | Software iSCSI, Dependent hardware iSCSI y Independent hardware iSCSI |

| Use unidirectional CHAP | El host requiere CHAP y falla si no funciona CHAP | Software iSCSI, Dependent hardware iSCSI y Independent hardware iSCSI |

| Use bidirectional CHAP | El host y el target requiren CHAP bidireccional | Software iSCSI, Dependent hardware iSCSI |

Tras seleccionar el motedo de autenticación, indicamos los valores de las credenciales de entrada y salida.

Determine use cases for fiber channel zoning

El zoning permite tener un mayor control del acceso de los servidores a la infraestructura SAN

- Se puede usar para separar distintos entornos

- Puede evitar que otros sistemas que no son ESXi accedan a las mimsas LUNs

- Controla y aísla los paths

- Disminuye la cantidad de LUNs que se presentan a un host

Compare and contrast array thin provisioning and virtual disk thin provisioning

El Thin Provisioning permite utilizar el almacenamiento disponible, de forma que se pueda asignar más capacidad de la disponible en el sistema, de forma que se pueda optimizar el uso de los recursos, lo que implica una continua monitorización del uso de los recursos.

Array Thin Provisioning En este caso es el sistema de almacenamiento quien se encarga de gestionar la asignación de los recursos y su ocupación en el sistema. El sistema de almacenamiento informa del tamaño lógico de la LUN al servidor ESXi, siendo mayor que la capacidad física real que respalda. Cuando se utiliza Storage APIs - Array Integration, el host puede integrarse con el almacenamiento físico y detectar la información de aprovisionamiento a nivel de LUN.

Virtual Disk Thin Provisioning En este caso, es el servidor ESXi el que se encarga de gestionar la asignación de espacio en el almacenamiento a los discos virtuales de las máquinas de la infraestructura. De esta forma el disco virtual sólo ocupa el espacio del tamaño de los datos que contiene, no el del total asignado.